Hadoop实战:Sqoop 1.99把MySQL导数据到HDFS

Sqoop客户端 sqoop2客户端提供各种命令行交互接口,供用户使用。sqoop2客户端先连接Sqoop Server,将参数传递过去,再调用mapreduce进行数据导入到出作业。以下是sqoop2中比较重要的几个对象。 1)connector:sqoop2中预定一了各种里链接,这些链接是一些配置模板,比如最基本的generic-jdbc-connect……

Hadoop实战:Sqoop 1.99命令使用

一、了解sqoop数据导入的几个重要概念 1)connector:sqoop2中预定了各种链接,这些链接是一些配置模板。 sqoop:000> show connector +------------------------+---------+--------------------------------------……

Hadoop实战:使用Maxwell将MySQL数据实时同步到HDFS

一、Maxwell介绍 Maxwell是一个守护程序,一个应用程序,能够读取MySQL Binlogs然后解析输出为json。支持数据输出到Kafka中,支持表和库过滤。 → Reference:http://maxwells-daemon.io → Download: https://github.com/zendesk/maxwell/releases/……

Hadoop实战:Flume输入日志到HDFS报错解决

使用Flume把日志存储到HDFS,在启动时报错如下: 2017-06-16 08:58:32,634 (conf-file-poller-0) [ERROR - org.apache.flume.node.PollingPropertiesFileConfigurationProvider$FileWatcherRunnabl……

Hadoop实战:Hive操作使用

Hive表类型测试 内部表 数据准备,先在HDFS上准备文本文件,逗号分割,并上传到/test目录,然后在Hive里创建表,表名和文件名要相同。 $ cat /tmp/table_test.csv 1,user1,1000 2,user2,2000 3,user3,3000 4,user4,4000 5,user5,……

Hadoop实战:Hadoop分布式集群部署(一)

一、系统参数优化配置 1.1 系统内核参数优化配置 修改文件/etc/sysctl.conf,使用sysctl -p命令即时生效。 kernel.shmmax = 500000000 kernel.shmmni = 4096 kernel.shmall = 4000000000 kernel.sem = 250 51200……

大数据生态到底是一个什么概念?

大数据这个概念本身就太大而且太宽,如果一定要严格定义是非常困难的一件事,不过Hadoop生态圈或者由其延伸的泛生态系统,基本上都是为了处理大量数据诞生的——一般而言,这种数据依赖单机很难完成。 这个圈子里的工具,就像是我们厨房里的各种厨具——各自都有不同的用处,但也有一部分功能重合,比如盆和豌都可以用来喝汤,削皮刀和菜刀都可以用来去皮。 但是,盆用来喝汤未免……

GreenPlum关闭启动及状态检查

gpstop [gpadmin@gpmaster ~]$ gpstop --help 1 [gpadmin@gpmaster ~]$ gpstop --help 常用的参数如下: -a,不需要输……

GreenPlum管理入门第一章

一、访问数据库 本篇文章主要记录GreenPlum数据库的登录和基本的帮助手册相关信息,GreenPlum数据库提供psql客户端程序访问数据库,下面是psql的帮助信息。 [gpadmin@gpmaster ~]$ psql --help 1 ……

GreenPlum部署指南(GPDB43InstallGuide中文版)

目录 章节一:介绍Greenplum 章节二:预估存储容量 章节三:系统环境配置 章节四:安装前环境配置 章节五:安装Greenplum 章节六:检查批量安装情况 章节七、创建数据存储区域 章节八:验证你的系统环境 章节十:验证你的硬件性能 章节十一:字符集问题 章节十二:初始化GreenPlum 章节十三:设置环境变量 章节十四:操作数据库 章节十五:增加……

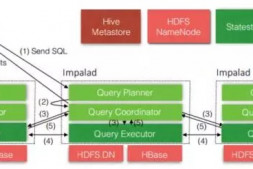

大数据时代快速SQL引擎-Impala

背景 随着大数据时代的到来,Hadoop在过去几年以接近统治性的方式包揽的ETL和数据分析查询的工作,大家也无意间的想往大数据方向靠拢,即使每天数据也就几十、几百M也要放到Hadoop上作分析,只会适得其反,但是当面对真正的Big Data的时候,Hadoop就会暴露出它对于数据分析查询支持的弱点。甚至出现《MapReduce: 一个巨大的……

- 1

- 2